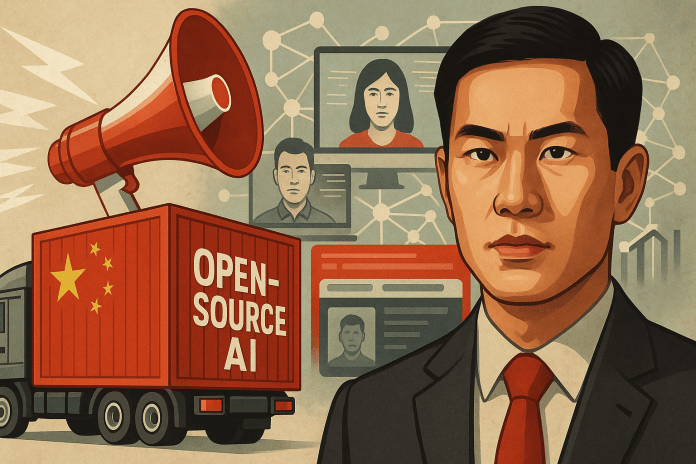

En un mundo donde la inteligencia artificial moldea la información que consumimos, un reciente informe de NewsGuard revela una tendencia preocupante: los principales modelos de IA chinos repiten o no corrigen afirmaciones falsas pro-China en el 60% de los casos. Pero, ¿qué significa esto? ¿Quién está detrás de esta estrategia? ¿Dónde y cuándo se implementa? Y, sobre todo, ¿por qué debería importarnos?

China ha encontrado en los modelos de IA de código abierto una forma económica y eficaz de difundir su narrativa oficial a escala global. Estos sistemas, accesibles y de bajo costo, están siendo adoptados por desarrolladores y empresas en todo el mundo, llevando consigo sesgos políticos y desinformación.

El hallazgo de NewsGuard: IA al servicio del Estado

NewsGuard, una organización que monitorea la credibilidad de la información en línea, analizó varios modelos de IA desarrollados en China. Los resultados son claros: estos sistemas tienden a reproducir afirmaciones propagandísticas sin cuestionarlas. Por ejemplo, minimizan violaciones de derechos humanos o justifican políticas controvertidas del gobierno chino.

Lo más alarmante es que estos modelos no solo se usan dentro de China, sino que se exportan como herramientas “neutrales” de código abierto, infiltrándose en aplicaciones globales sin que los usuarios finales lo noten.

¿Por qué el código abierto es clave en esta estrategia?

El código abierto permite que cualquiera pueda modificar y distribuir software libremente. China ha aprovechado esto para crear modelos accesibles que, aunque técnicamente avanzados, incluyen sesgos políticos sutiles. Al ser adoptados por startups y empresas en Occidente, estos sistemas normalizan narrativas favorables al gobierno chino sin necesidad de censura directa.

Además, al ser gratuitos o de bajo costo, compiten con alternativas occidentales más caras, ganando terreno en mercados emergentes donde la verificación de datos es menos rigurosa.

El impacto global: Desinformación a escala algorítmica

Esta estrategia no solo afecta a los usuarios chinos. Al integrarse en plataformas globales, estos modelos pueden influir en:

– Noticias falsas: Reproduciendo narrativas estatales sin contexto crítico.

– Redes sociales: Generando contenido automatizado con sesgo político.

– Herramientas empresariales: Sesgando análisis de datos o chatbots corporativos.

El resultado es una normalización silenciosa de la propaganda, donde la IA actúa como un embajador digital del gobierno chino.

¿Estamos preparados para la IA como arma política?

La inteligencia artificial ya no es solo una herramienta tecnológica; es un campo de batalla geopolítico. Si no establecemos mecanismos de transparencia y auditoría, corremos el riesgo de que algoritmos sesgados moldeen percepciones masivas sin que nadie lo note.

¿Deberían regularse los modelos de IA de código abierto? ¿Cómo podemos distinguir entre innovación y manipulación? La conversación apenas comienza.