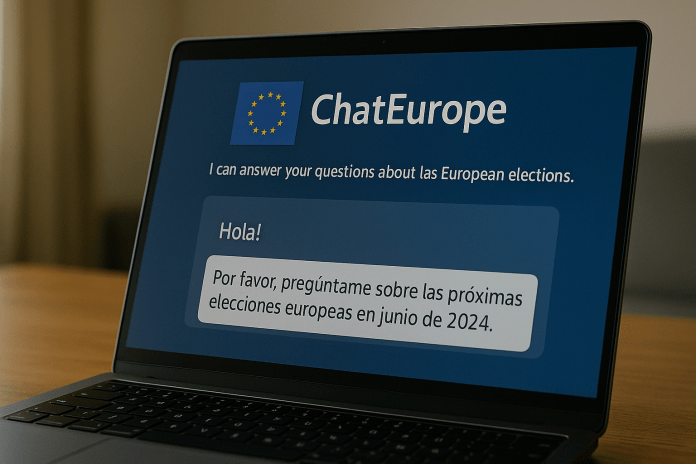

¿Qué pasa cuando un chatbot financiado con fondos públicos da información errónea sobre temas tan delicados como las elecciones europeas? En mayo de 2024, la Unión Europea lanzó ChatEurope, un chatbot multilingüe creado para responder preguntas ciudadanas sobre el proceso electoral. ¿El problema? Entrega respuestas obsoletas, confusas o directamente falsas. ¿Quién lo desarrolló? ¿Por qué falla? ¿Qué nos dice esto sobre el uso político de la IA? Esta es la historia de cómo una buena idea mal ejecutada puede volverse un riesgo comunicacional.

🤖 ¿Qué es ChatEurope y por qué se creó?

ChatEurope es un chatbot financiado por el programa europeo Horizon, con el objetivo de brindar información confiable y neutral sobre las elecciones europeas de 2024. Opera en 16 idiomas y se basa en tecnologías de IA generativa como ChatGPT, Bing y Claude, a través de una capa de integración llamada Prometheus.

Su creación fue anunciada con bombos y platillos: una IA multilingüe, transparente, de código abierto y con enfoque ciudadano. Ideal en teoría. Pero en la práctica…

🧨 El problema: respuestas equivocadas y desactualizadas

Medios como The Decoder y usuarios de X (antes Twitter) detectaron fallos preocupantes. El chatbot entrega datos incorrectos sobre la fecha de las elecciones, los candidatos y las competencias del Parlamento Europeo.

Ejemplos:

- Asegura que las elecciones de 2024 ya han terminado (cuando aún no comenzaban).

- Dice que hay 705 escaños en el Parlamento, cuando en realidad serán 720.

- Describe mal los poderes legislativos del organismo.

Además, ChatEurope no se actualiza en tiempo real y no informa sus fuentes, lo que genera confusión y falta de confianza.

🚫 ¿Por qué falló ChatEurope?

- Falta de actualización en tiempo real: La IA usada no accede a fuentes en vivo.

- Confianza ciega en modelos generativos: La lógica de ChatEurope prioriza respuestas rápidas, no necesariamente precisas.

- Sin revisión humana activa: No hay moderación ni verificación de las respuestas generadas.

- Errores de arquitectura: El sistema se basa en una capa intermedia (Prometheus) que no corrige las alucinaciones de los modelos base.

📉 Riesgos de usar IA generativa sin control humano

Este caso es paradigmático: cuando se usa IA sin supervisión adecuada, los errores no solo son posibles, sino inevitables. Y cuando hablamos de procesos electorales o derechos ciudadanos, esos errores pueden tener consecuencias políticas, sociales y éticas graves.

Este episodio reabre el debate sobre:

- La necesidad de control humano significativo.

- La transparencia en los datasets y arquitecturas utilizadas.

- La regulación urgente del uso de IA en contextos gubernamentales.

🧠 ¿IA para informar o para desinformar?

En NadIA Personal defendemos el uso crítico, ético y contextualizado de la inteligencia artificial. El caso de ChatEurope no es una anécdota: es una advertencia. La IA puede ayudar a informar, sí, pero solo si se la entrena, se la revisa y se la usa con responsabilidad. De lo contrario, termina replicando el viejo problema: más ruido que señales.

¿Tienes una IA que no te pesca? Acá en NadIA Personal sí hacemos asesorías… y las respuestas no están alucinadas.